引言

在工业4.0与智能制造转型浪潮下,3D视觉引导技术凭借其高精度、强适应性和智能化特征,已成为工业机器人实现自主作业的核心使能技术。然而,复杂工业场景中的动态环境、多样工件与严苛效率要求,对3D视觉系统提出多重挑战。作为工业自动化设备的核心供应商,我们深入剖析行业痛点并提出系统性解决方案,推动视觉引导技术从“可用”向“高效可靠”跨越。

一、工业场景下3D视觉引导的六大核心痛点

1.精度与速度的平衡难题

高精度点云重建需牺牲扫描速度,而高速扫描易导致数据质量下降,难以满足产线节拍要求。

典型场景:汽车焊装线中对0.1mm级精度的车身钣金件定位需求与秒级响应的矛盾。

2.复杂环境适应性不足

反光、透明、黑色物体(如玻璃、橡胶件)导致点云缺失或噪点;多工件堆叠、无序摆放增加识别难度。

3.动态场景处理能力局限

传送带振动、光照变化、工件位姿实时偏移等干扰因素,影响视觉系统的稳定性与鲁棒性。

4.系统集成复杂度高

视觉系统与机器人、PLC、MES等设备的协同调试周期长,二次开发成本居高不下。

5.长尾场景覆盖不足

非标工件、小批量定制化产线的视觉方案开发效率低,难以快速响应市场需求。

6.成本与性能的权衡困境

工业级3D相机与算法的高昂投入,制约中小型企业技术升级意愿。

二、设备商的创新解决路径与技术突破

针对上述痛点,设备商需从硬件革新、算法优化、系统集成三大维度构建全栈技术能力:

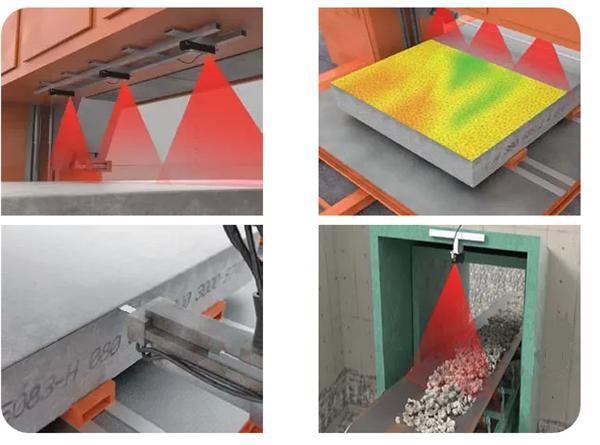

1. 硬件层:多模态传感器融合与算力升级多光谱成像技术:结合结构光、ToF、激光扫描等多传感器数据,解决反光/透明物体成像难题。

边缘计算嵌入式设计:在相机端集成AI芯片(如GPU/FPGA),实现点云预处理与特征提取,降低数据传输延迟。

案例实践:某汽车零部件厂商采用多光谱3D相机后,黑色橡胶件定位成功率从72%提升至98%。

自适应点云分割算法:通过神经网络自动识别工件边缘与特征点,减少人工参数调校依赖。

动态场景补偿模型:基于卡尔曼滤波与视觉伺服技术,实时修正机器人运动轨迹以应对振动与偏移。

小样本学习框架:针对长尾场景,利用迁移学习与生成对抗网络(GAN)快速生成合成数据,缩短模型训练周期。

软硬件解耦架构:提供标准通信接口(如EtherCAT、PROFINET)与SDK工具包,支持与主流机器人品牌快速对接。

工艺知识库沉淀:将行业Know-How(如焊接路径规划、抓取策略)封装为可配置模块,降低客户二次开发门槛。

云边端协同方案:通过云端算法迭代与边缘端轻量化部署,实现系统性能持续优化。

三、行业价值与未来展望

通过上述技术突破,设备商可为客户带来显著效益:

效率提升:某电子装配线引入3D视觉引导后,机器人节拍时间缩短30%,OEE(设备综合效率)提升22%;

成本优化:模块化方案使系统部署周期从6周压缩至72小时,人力调试成本降低60%;

柔性扩展:支持1000+种SKU的混合分拣,适应多品种、小批量生产趋势。

未来,3D视觉技术将向“感知-决策-控制”一体化方向发展,结合数字孪生与5G实时通信,构建全场景自主化智能工厂。设备商需持续聚焦开放性、易用性、泛化性三大核心指标,推动视觉系统从“单点工具”进化为“智能制造神经中枢”。

结语

3D视觉引导技术的成熟,标志着工业自动化从“机械执行”迈向“智能感知”的新阶段。设备商唯有以场景驱动创新,攻克精度、速度、成本与易用性之间的“不可能三角”,方能助力制造业客户在智能化竞争中抢占先机。